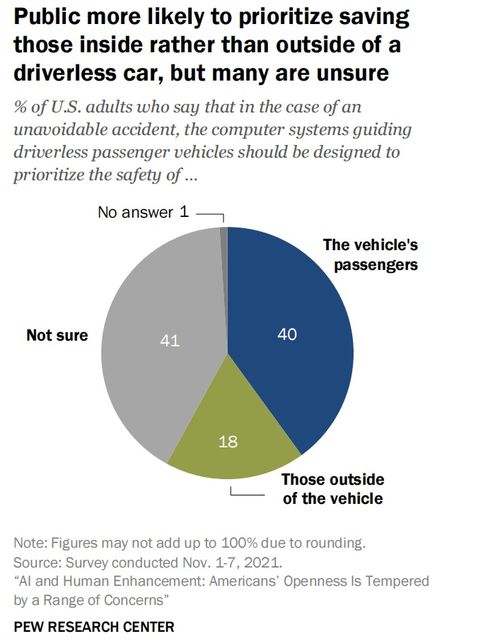

皮尤研究中心(Pew Research Center)发布了一份关于美国民众对人工智能(AI)应用态度的深度调研报告。这份报告不仅揭示了公众对AI技术在不同领域应用的复杂情感与担忧,也为从事人工智能应用软件开发的从业者、政策制定者及企业提供了至关重要的公众视角与治理线索。

一、 调研核心发现:谨慎的乐观与深刻的担忧并存

报告显示,美国公众对AI的态度并非铁板一块,而是呈现出高度情境化的特征。在医疗健康(如辅助诊断)、科学研究等关乎公共福祉的领域,民众表现出相对较高的接受度与期待,认为AI有望带来突破性进步。在涉及个人隐私、就业安全、执法监控及社交媒体内容推荐等领域,担忧情绪则显著上升。民众普遍担心AI可能导致个人数据滥用、加剧社会不平等、替代人类工作岗位,并在关键决策中缺乏透明度和问责机制。

这种“领域特异性”的态度表明,公众并非笼统地拒绝或拥抱AI,而是基于其应用场景、潜在风险与收益进行审慎评估。这对开发者而言是一个明确信号:技术的接受度与其社会影响的感知直接相关。

二、 对人工智能应用软件开发的直接启示

- 以价值为导向的设计:软件开发不应仅仅追求技术的新颖性或功能的强大,而应从一开始就将社会价值、伦理考量与用户体验置于核心。例如,在开发用于招聘、信贷评估的AI系统时,必须将公平性、可解释性和偏见缓解机制内嵌于算法模型与产品设计中。

- 透明化与用户赋权:报告凸显了公众对“黑箱”操作的不信任。因此,应用软件需要提供清晰的界面,告知用户AI何时被使用、基于哪些数据、做出了何种推断或建议,并尽可能以通俗语言解释其工作原理。应赋予用户选择权和控制权,例如允许用户调整个性化推荐的参数,或选择退出某些基于AI的数据分析。

- 隐私保护的前置化:鉴于对数据滥用的深切担忧,开发者在数据收集、存储、处理和使用等各个环节,都必须遵循“隐私设计”原则。这意味着需要采用数据最小化、匿名化、加密等先进技术,并在隐私政策中进行清晰、诚实的沟通,而非事后补救。

- 聚焦增强而非替代:在容易引发就业焦虑的领域,如客户服务、内容创作等,AI应用的设计思路应强调“增强人类能力”,即作为工具辅助人类提高效率与创造力,而非完全取代人的角色。这有助于缓解社会阻力,并创造更可持续的人机协作模式。

三、 指向更广泛的人工智能治理

公众的态度是构建有效AI治理框架的基石。报告中的担忧直接指向了当前治理的短板:

- 需要健全的法律法规:公众期待明确的规则来约束AI的研发与应用,特别是在高风险领域。这要求政策制定者加快步伐,出台关于算法审计、责任认定、数据权利等方面的法律。

- 推动多方参与的治理模式:AI治理不能仅靠政府或科技公司。报告暗示了建立包括技术专家、伦理学家、社会科学家、公众代表及行业组织在内的多元协同治理机制的必要性,以确保各方视角与利益得到平衡。

- 加强公众教育与沟通:许多担忧源于对AI技术的不了解。开发者、企业和研究机构有责任开展公众科普,用事实减少误解,同时坦诚讨论技术的局限性与风险,共同塑造负责任的创新文化。

结论

皮尤的调研报告如同一面镜子,映照出社会对AI革命既期待又不安的复杂心态。对于人工智能应用软件开发者而言,这绝非遥远的背景噪音,而是产品能否获得长期社会认可和市场成功的关键输入。成功的AI应用,必然是那些在追求技术进步的能积极回应公众核心关切、将伦理与治理内化于设计之中、致力于解决真实问题并为社会创造普惠价值的产物。未来的竞争,不仅是算法与算力的竞争,更是信任与责任的竞争。